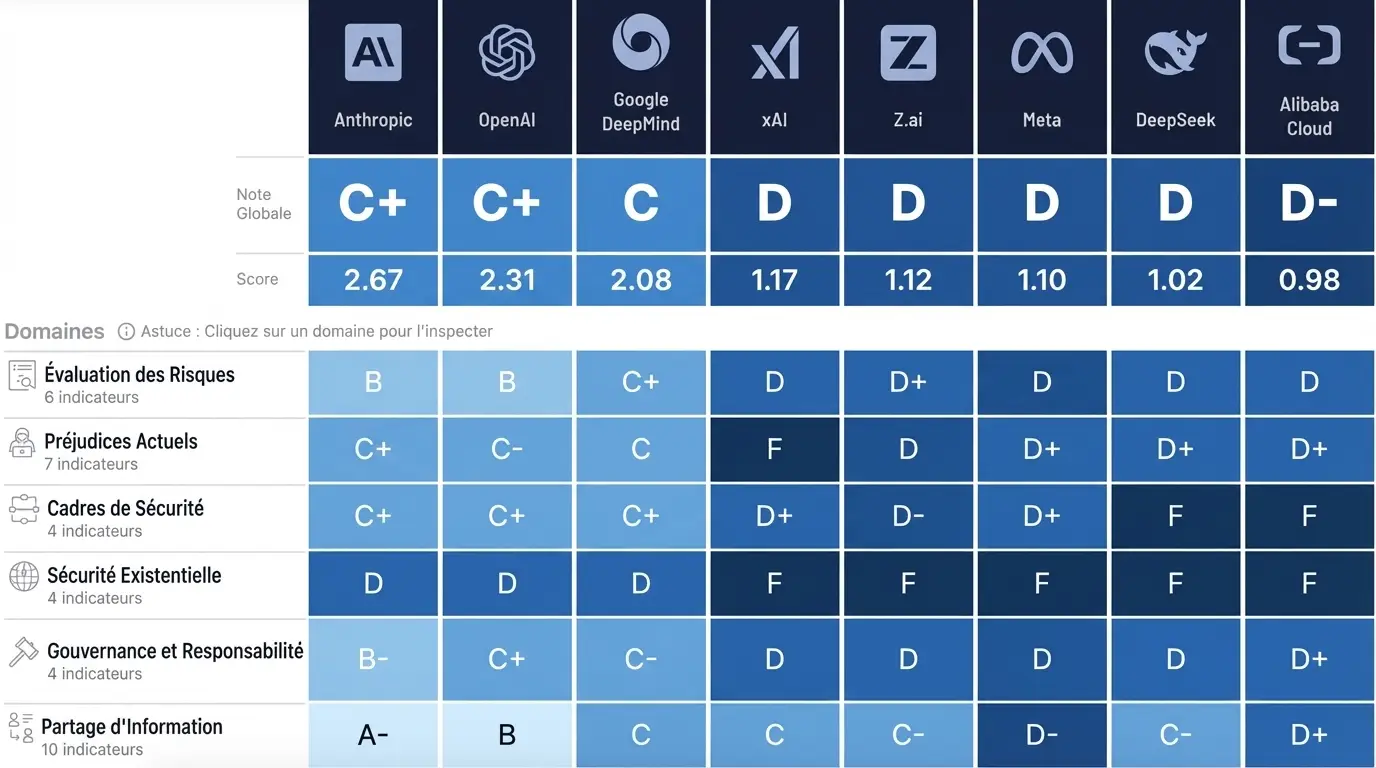

Le 3 décembre 2025, un rapport a fait trembler la Silicon Valley. Pas un tremblement de terre. Pas une faillite retentissante. Quelque chose de plus profond. Le Future of Life Institute venait de publier son AI Safety Index Winter 2025. Le verdict était sans appel. Aucune entreprise d’intelligence artificielle au monde n’obtient une note supérieure à C+. Huit géants technologiques passés au crible. Trente-cinq indicateurs analysés. Six catégories évaluées. Et un constat glaçant : personne n’est prêt face aux risques majeurs de l’IA.

Cette évaluation indépendante bouleverse nos certitudes. OpenAI, créateur de ChatGPT. Google DeepMind, pionnier de l’IA. Meta, mastodonte des réseaux sociaux. Tous échouent. Tous présentent des lacunes structurelles en matière de sécurité IA entreprise. Le professeur Stuart Russell, sommité mondiale de l’intelligence artificielle à Berkeley, résume la situation avec une formule terrifiante. Les dirigeants de ces entreprises admettent que le risque de perte de contrôle pourrait atteindre un sur trois. Pourtant, ils continuent leur course effrénée vers l’intelligence artificielle générale.

Le Verdict Sans Appel du Future of Life Institute

Un Bulletin de Notes Qui Fait Froid dans le Dos

Le Future of Life Institute n’est pas un observateur ordinaire. Fondé en 2014, cet organisme à but non lucratif rassemble des scientifiques, des chercheurs et des penseurs préoccupés par les risques existentiels. Son président, Max Tegmark, enseigne la physique au MIT. Sa mission est claire : garantir que les technologies avancées bénéficient à l’humanité plutôt qu’elles ne la menacent.

L’AI Safety Index représente leur outil d’évaluation le plus ambitieux. Un panel de huit experts indépendants a scruté les pratiques de sécurité de huit entreprises majeures. Parmi eux, Stuart Russell de Berkeley. David Krueger de l’Université de Montréal. Tegan Maharaj de HEC Montréal. Des sommités reconnues internationalement.

Les résultats publiés le 3 décembre 2025 sont accablants. Anthropic obtient la meilleure note globale avec un modeste C+. OpenAI suit avec un C+ également. Google DeepMind décroche un C. Ensuite, c’est la chute libre. xAI d’Elon Musk récolte un D. Z.ai et Meta obtiennent également un D. DeepSeek se contente d’un D. Alibaba Cloud ferme la marche avec un D-.

Comme le souligne le rapport complet du Future of Life Institute, « un fossé clair persiste entre les trois premiers (Anthropic, OpenAI et Google DeepMind) et le reste des entreprises évaluées ». Ce fossé s’élargit de trimestre en trimestre. Les capacités des modèles progressent plus vite que les pratiques de gestion des risques.

Les Six Critères de l’Audit Mondial

L’évaluation repose sur six domaines fondamentaux. Chacun examine une facette critique de la sécurité IA entreprise.

Le premier critère, l’évaluation des risques, mesure la rigueur des tests effectués avant le déploiement des modèles. Seules trois entreprises sur sept effectuent des tests substantiels pour les capacités dangereuses liées au bioterrorisme ou aux cyberattaques. Anthropic, OpenAI et Google DeepMind. Les autres négligent ces évaluations fondamentales.

Le deuxième critère analyse les préjudices actuels. Il évalue comment les entreprises gèrent les dommages déjà causés par leurs technologies. Discrimination algorithmique. Désinformation massive. Manipulation psychologique. Anthropic se distingue avec la seule note B- dans cette catégorie. Les autres peinent à atteindre la moyenne.

Le troisième critère examine les cadres de sécurité. Ces protocoles définissent les garde-fous techniques et organisationnels. DeepSeek, Z.ai et Alibaba Cloud n’ont publié aucun cadre de sécurité accessible au public. Cette absence totale de transparence leur vaut des notes éliminatoires.

Le quatrième critère porte sur la sécurité existentielle. C’est le point le plus critique. Toutes les entreprises obtiennent un D ou moins. Aucune n’a présenté de stratégie concrète pour contrôler une intelligence artificielle superintelligente.

Le cinquième critère évalue la gouvernance et la responsabilité. Structure organisationnelle. Politiques de dénonciation. Mécanismes de surveillance interne. OpenAI se démarque comme la seule entreprise ayant publié intégralement sa politique de protection des lanceurs d’alerte.

Le sixième critère mesure le partage d’informations. Transparence des évaluations. Publication des incidents. Collaboration avec les régulateurs. Anthropic et OpenAI obtiennent des A et des B dans ce domaine. Les entreprises chinoises échouent systématiquement.

Le Podium des Médiocres : Anthropic, OpenAI, Google

Parler de « meilleurs élèves » serait trompeur. Anthropic, OpenAI et Google DeepMind dominent un classement où personne n’excelle. Leur avance relative masque des insuffisances profondes.

Anthropic se distingue par plusieurs initiatives pionnières. L’entreprise a conduit les seuls essais de biosécurité avec des participants humains. Elle refuse d’entraîner ses modèles sur les données des utilisateurs, protégeant ainsi la confidentialité. Sa recherche sur l’alignement des IA reste la plus avancée du secteur. Sa structure de Public Benefit Corporation témoigne d’un engagement gouvernance au-delà du simple profit.

Toutefois, même Anthropic faiblit sur la sécurité existentielle. Son score D dans cette catégorie révèle l’absence de plan concret face à une IA qui dépasserait l’intelligence humaine. L’entreprise a récemment modifié sa politique de « responsible scaling ». Ces changements ont supprimé certains engagements concernant les menaces internes. Les évaluateurs ont qualifié ce recul de « très mauvais processus ».

OpenAI occupe la deuxième place grâce à sa transparence relative. L’entreprise a documenté un processus d’évaluation des risques plus large que ses concurrents. Elle publie régulièrement des cas d’utilisation malveillante détectés. Sa transformation en Public Benefit Corporation, bien que critiquée, représente une amélioration structurelle.

Néanmoins, OpenAI souffre d’un déficit de crédibilité. Les départs successifs de ses équipes de sécurité ont affaibli sa capacité d’action. Le rapport recommande explicitement de « reconstruire la capacité perdue des équipes de sécurité ». La course aux nouvelles fonctionnalités semble primer sur la prudence.

Google DeepMind complète ce podium avec un C. L’entreprise dispose d’un Frontier Safety Framework définissant des protocoles pour les risques graves. Sa recherche fondamentale en sécurité IA reste substantielle. Pourtant, les évaluateurs pointent un problème de coordination. Les équipes de sécurité de DeepMind et les équipes politiques de Google communiquent insuffisamment.

Un incident récent illustre cette faille. Google a lancé Gemini 2.5, un modèle frontière, sans publier d’informations de sécurité. Le fondateur de SaferAI a qualifié cet oubli d’« échec flagrant ». Cette négligence a fait chuter le score de Google par rapport à l’évaluation précédente.

La Chute Vertigineuse : Meta, xAI et les Acteurs Chinois

En dessous du podium, c’est le désert. Meta, xAI, Z.ai, DeepSeek et Alibaba Cloud obtiennent des notes qui feraient rougir n’importe quel étudiant. Leur point commun : l’absence d’engagements contraignants en matière de sécurité.

Meta illustre parfaitement ce paradoxe. L’entreprise investit des milliards dans la recherche IA. Elle a annoncé ses ambitions vers la superintelligence. Pourtant, elle refuse de répondre à l’enquête du Future of Life Institute. Elle est la seule entreprise américaine à ignorer cette sollicitation. Son score D reflète cette opacité volontaire.

Le rapport identifie des lacunes majeures chez Meta. Aucune preuve d’investissement substantiel dans la recherche en sécurité. Pas de cadre de surveillance des risques publié. Pas d’engagement vers une gouvernance responsable. L’entreprise de Mark Zuckerberg privilégie la vitesse de déploiement sur la prudence.

xAI d’Elon Musk présente un cas particulier. L’entreprise a progressé depuis octobre 2024. Son score est passé de 0% à 18% dans l’évaluation SaferAI. Mais cette amélioration part de si bas qu’elle reste insuffisante. Ironiquement, Musk est conseiller du Future of Life Institute et a financé l’organisme par le passé. Cette proximité n’a pas empêché xAI de répondre « Legacy Media Lies » (les médias traditionnels mentent) à la demande de commentaire.

DeepSeek et Alibaba Cloud : L’Angle Mort Chinois

Les entreprises chinoises posent un problème distinct. DeepSeek, Z.ai et Alibaba Cloud opèrent sous un cadre réglementaire différent. La Chine dispose déjà de réglementations sur l’IA générative depuis août 2023. Les « Mesures provisoires pour la gestion des services d’IA générative » imposent des évaluations de sécurité supervisées par le gouvernement.

Cependant, ces réglementations chinoises ne couvrent pas les risques frontières. Une version préliminaire de février 2024 mentionnait ces risques. La version actuelle les a supprimés. Cette omission inquiète les observateurs occidentaux.

Le rapport note une nuance importante. Les normes d’auto-gouvernance et de partage d’informations sont moins ancrées dans la culture d’entreprise chinoise. Comparer directement les entreprises chinoises et américaines sur ces critères présente donc des limites méthodologiques.

Néanmoins, l’absence totale de cadre de sécurité publié chez DeepSeek, Z.ai et Alibaba Cloud reste préoccupante. Ces entreprises développent des modèles de plus en plus puissants. Elles le font sans la transparence minimale que les experts jugent nécessaire.

Sécurité Existentielle : Le Trou Noir de l’Industrie

La catégorie « sécurité existentielle » révèle la faille la plus profonde. Aucune entreprise n’obtient mieux qu’un D. Plusieurs récoltent un F. Ce constat unanime dépasse les clivages géographiques et culturels.

Que mesure exactement ce critère ? Il évalue si les entreprises ont publié des stratégies concrètes pour gérer les risques catastrophiques. Ces risques incluent la perte de contrôle sur une IA superintelligente. Ils incluent également l’utilisation de l’IA pour créer des armes biologiques. Ou pour déstabiliser des gouvernements. Ou pour manipuler les populations à grande échelle.

Toutes les entreprises évaluées déclarent vouloir construire une intelligence artificielle générale. Certaines visent même la superintelligence. Pourtant, aucune n’a présenté de plan explicite pour contrôler ces technologies. Le rapport qualifie cette situation de « faille structurelle fondamentale du secteur ».

Max Tegmark résume le paradoxe avec clarté. Ces entreprises affirment savoir comment construire des machines plus intelligentes que les humains. Pourtant, elles ne peuvent pas expliquer comment elles empêcheront l’humanité de perdre le contrôle. « La vérité est que personne ne sait comment contrôler une nouvelle espèce bien plus intelligente que nous », affirme-t-il.

Stuart Russell : « Un Risque de Un sur Trois »

Stuart Russell apporte la perspective la plus alarmante. Ce professeur de Berkeley dirige le Center for Human-Compatible AI. Il a coécrit le manuel de référence en intelligence artificielle, utilisé dans plus de 1 500 universités. Ses mots portent le poids de décennies d’expertise.

Sa déclaration mérite d’être citée intégralement. « Les PDG de l’IA prétendent savoir comment construire une IA surhumaine. Pourtant, aucun ne peut montrer comment ils empêcheront la perte de contrôle. Après quoi, la survie de l’humanité ne sera plus entre nos mains. »

Russell établit ensuite une comparaison saisissante. « Je cherche la preuve qu’ils peuvent réduire le risque annuel de perte de contrôle à un sur cent millions, conformément aux exigences des réacteurs nucléaires. Au lieu de cela, ils admettent que le risque pourrait être de un sur dix. Ou de un sur cinq. Voire de un sur trois. Et ils ne peuvent ni justifier ni améliorer ces chiffres. »

Cette comparaison avec l’industrie nucléaire est révélatrice. Les centrales nucléaires sont soumises à des normes de sécurité draconniennes. Chaque composant est testé. Chaque procédure est documentée. Le risque d’accident majeur doit rester infinitésimal. L’industrie de l’IA opère sans contraintes comparables.

Russell conclut avec une mise en garde ultime. « Il est possible que la direction technologique actuelle ne puisse jamais soutenir les garanties de sécurité nécessaires. Dans ce cas, c’est vraiment une impasse. »

Pourquoi les Géants Échouent-ils Collectivement ?

L’échec généralisé de l’industrie n’est pas accidentel. Il résulte de dynamiques structurelles que Max Tegmark analyse avec lucidité. « Je sens que les dirigeants de ces entreprises sont piégés dans une course vers le bas dont aucun d’eux ne peut sortir, aussi bienveillants soient-ils. »

Cette course vers le bas s’explique par l’absence de régulation contraignante. Aux États-Unis et au Royaume-Uni, où opèrent la plupart de ces entreprises, aucune loi fédérale ne régit le développement de l’IA frontière. Les engagements volontaires ne suffisent pas. Ils créent un désavantage compétitif pour les entreprises qui les respectent.

Tegmark illustre ce paradoxe avec une analogie parlante. L’industrie de l’IA est la seule aux États-Unis à fabriquer une technologie puissante moins réglementée que les sandwichs. « Si vous voulez ouvrir un nouveau restaurant près de Times Square, vous devez d’abord convaincre un inspecteur sanitaire que votre cuisine n’est pas infestée de rats. Si vous dites que vous allez plutôt vendre une IA superintelligente, personne ne vient vérifier quoi que ce soit. »

Cette asymétrie réglementaire crée une incitation perverse. Les entreprises qui investissent massivement dans la sécurité se retrouvent désavantagées. Leurs concurrents moins scrupuleux sortent des produits plus rapidement. Ils captent des parts de marché. Ils attirent des investisseurs. Le marché récompense la vitesse, pas la prudence.

La Course à l’AGI Sans Filet de Sécurité

Le rapport met en lumière un écart grandissant. Les capacités des modèles d’IA progressent exponentiellement. Les pratiques de gestion des risques évoluent linéairement. Cet écart s’élargit à chaque nouvelle génération de modèles.

Les évaluateurs ont collecté leurs données jusqu’au 8 novembre 2025. Depuis, plusieurs modèles majeurs ont été lancés. Gemini 3 Pro de Google DeepMind. Grok 4.1 de xAI. GPT-5.1 d’OpenAI. Claude Opus 4.5 d’Anthropic. Chaque nouveau modèle repousse les frontières des capacités. Les garde-fous ne suivent pas.

Un exemple concret illustre ce décalage. Seules trois entreprises sur huit testent substantiellement les capacités dangereuses liées au bioterrorisme. Les cinq autres ne le font pas. Ou pas suffisamment. Pourtant, la capacité des modèles à aider à la conception d’agents pathogènes progresse.

Un évaluateur anonyme exprime son inquiétude. « La méthodologie liant explicitement une procédure d’évaluation au risque, avec ses limites et qualifications, est généralement absente. J’ai très peu confiance que les capacités dangereuses soient détectées à temps pour prévenir des dommages significatifs. »

Vers une Régulation : L’Espoir ou l’Illusion ?

Face à ce constat, des initiatives réglementaires émergent. La Californie a récemment adopté une loi pionnière. Elle impose aux entreprises d’IA frontière de divulguer des informations de sécurité concernant les risques catastrophiques. New York prépare une législation similaire.

Au niveau fédéral américain, les espoirs restent minces. L’industrie technologique dispose d’un pouvoir de lobbying considérable. Le rapport note qu’OpenAI et d’autres entreprises font pression contre les réglementations étatiques axées sur la sécurité de l’IA.

L’Union européenne avance plus rapidement avec son AI Act. Plusieurs entreprises américaines se sont engagées à signer le Code de Pratique associé. Toutefois, l’application concrète de ces engagements reste à démontrer.

Max Tegmark garde un optimisme prudent. « Oui, nous avons de gros problèmes et les choses vont dans une mauvaise direction. Mais je veux souligner à quel point c’est facile à corriger. Nous devons simplement avoir des normes de sécurité contraignantes pour les entreprises d’IA. »

Il propose un modèle inspiré de la FDA pour les médicaments. Une agence où les entreprises devraient d’abord convaincre des experts que leurs modèles sont sûrs avant de pouvoir les commercialiser. Cette idée simple se heurte à la résistance de l’industrie.

Le rapport du Future of Life Institute n’est pas qu’un exercice académique. Il constitue un outil de pression publique. En rendant visibles les défaillances, il permet aux investisseurs, aux régulateurs et au public de demander des comptes. L’index est désormais pris au sérieux par l’industrie. Quatre des cinq entreprises américaines répondent à son enquête.

Conclusion

Le 3 décembre 2025 restera comme un réveil brutal. L’AI Safety Index Winter 2025 confirme ce que beaucoup redoutaient. Les géants de l’intelligence artificielle ne sont pas prêts face aux risques qu’ils créent. Anthropic, OpenAI, Google DeepMind obtiennent des notes médiocres. Meta, xAI et les acteurs chinois échouent plus gravement encore.

La sécurité IA entreprise n’est plus un sujet de niche. Elle devient un enjeu civilisationnel. Huit entreprises se lancent dans une course vers l’intelligence artificielle générale. Aucune n’a de plan crédible pour contrôler ce qu’elle construit. Le risque de perte de contrôle, selon leurs propres estimations, pourrait atteindre un sur trois.

Cette situation n’est pas une fatalité. La solution existe. Des normes contraignantes. Une supervision indépendante. Une transparence obligatoire. Ces mesures ont fait leurs preuves dans l’industrie nucléaire, pharmaceutique, aéronautique. Elles peuvent s’appliquer à l’IA.

Chez Baair, nous croyons que l’intelligence artificielle doit servir l’humain, pas le menacer. Cette conviction guide notre approche de l’IA appliquée au design et à l’entreprise. L’innovation responsable n’est pas un frein. C’est une condition de durabilité.

La question n’est plus de savoir si nous devons agir. Mais si nous agirons à temps.

FAQ

1. Qu’est-ce que l’AI Safety Index du Future of Life Institute ?

L’AI Safety Index est une évaluation indépendante publiée par le Future of Life Institute. Ce rapport analyse les pratiques de sécurité IA entreprise des principaux acteurs mondiaux. Il examine 35 indicateurs répartis en six catégories : évaluation des risques, préjudices actuels, cadres de sécurité, sécurité existentielle, gouvernance et partage d’informations. Un panel de huit experts, dont Stuart Russell de Berkeley, attribue des notes de A à F à chaque entreprise.

2. Quelles entreprises obtiennent les meilleures notes en sécurité IA ?

Anthropic et OpenAI partagent la première place avec un C+. Google DeepMind suit avec un C. Ces trois entreprises américaines dominent le classement, mais leurs notes restent médiocres. Elles se distinguent par leurs tests de capacités dangereuses, leurs politiques de dénonciation et leur transparence relative. Cependant, toutes échouent en sécurité existentielle avec des D ou moins.

3. Pourquoi Meta et xAI obtiennent-ils de mauvaises notes ?

Meta et xAI obtiennent un D dans l’AI Safety Index. Ces entreprises n’ont pas fourni de preuves d’investissement substantiel dans la recherche en sécurité IA. Meta refuse de répondre à l’enquête du Future of Life Institute. xAI, malgré une amélioration depuis octobre 2024, part d’un score initial de 0%. L’absence de cadres de sécurité publiés et d’engagements contraignants explique leurs mauvaises performances.

4. Que signifie le critère de sécurité existentielle ?

La sécurité existentielle évalue si les entreprises ont publié des stratégies concrètes pour gérer les risques catastrophiques. Ces risques incluent la perte de contrôle sur une IA superintelligente, l’aide à la création d’armes biologiques ou la déstabilisation de gouvernements. Aucune entreprise n’obtient mieux qu’un D dans cette catégorie. Stuart Russell note que les dirigeants admettent un risque de perte de contrôle pouvant atteindre un sur trois.

5. Comment les entreprises chinoises performent-elles en sécurité IA ?

Les entreprises chinoises (Z.ai, DeepSeek, Alibaba Cloud) obtiennent des notes de D à D-. Elles n’ont publié aucun cadre de sécurité accessible au public. Le rapport note toutefois que les normes d’auto-gouvernance sont moins ancrées dans la culture d’entreprise chinoise. La Chine dispose par ailleurs de réglementations gouvernementales sur l’IA générative depuis 2023, ce qui réduit la dépendance à l’auto-régulation.

6. Quelles solutions propose le Future of Life Institute ?

Max Tegmark préconise des normes de sécurité contraignantes pour l’industrie de l’IA. Il propose un modèle inspiré de la FDA où les entreprises devraient prouver la sécurité de leurs modèles avant commercialisation. Le rapport recommande également plus de transparence, des audits externes indépendants, des politiques de dénonciation robustes et une coordination internationale sur les standards de sécurité IA entreprise.