Thomas, consultant indépendant en transformation digitale, fixe son écran avec un mélange de fascination et d’incrédulité. Il vient de passer les six dernières heures à construire manuellement un workflow N8N censé trier ses emails, extraire les factures, et alimenter automatiquement son Google Sheet de comptabilité. Six heures à jongler entre la documentation officielle, des tutoriels YouTube approximatifs, et une succession d’erreurs cryptiques qu’il ne comprend qu’à moitié. Son workflow fonctionne enfin, mais il est épuisé, frustré, et conscient qu’un développeur expérimenté aurait probablement accompli le même résultat en quarante-cinq minutes. Cette scène, banale pour quiconque s’aventure dans l’automatisation sans formation technique poussée, illustre le paradoxe cruel de N8N : la plateforme promet de démocratiser l’automatisation en éliminant le besoin de coder, mais elle exige en contrepartie une courbe d’apprentissage vertigineuse où comprendre la logique des nœuds, maîtriser les expressions JSON, et anticiper les flux de données devient un métier à part entière. Pourtant, une révolution silencieuse est en marche. Grâce à l’intelligence artificielle et plus précisément à Claude Opus 4 entraîné sur deux mille workflows réels, cette barrière technique s’effondre. Désormais, décrire son besoin en une phrase suffit pour voir le workflow complet se matérialiser et s’installer automatiquement dans votre instance. Explorons cette mutation qui transforme l’automatisation d’un art technique réservé aux initiés en une conversation accessible à tous.

Le Mur Invisible de l’Automatisation No-Code

Lorsque Thomas découvre N8N il y a huit mois, la promesse marketing le séduit immédiatement. « Automatisez n’importe quel processus sans coder » proclame le site officiel. L’interface visuelle, avec ses nœuds colorés qu’il suffit de glisser-déposer et de relier par des flèches, semble effectivement accessible. Les tutoriels d’introduction montrent des exemples triviaux qui fonctionnent en trois clics : recevoir un webhook, envoyer un email, c’est fait. Thomas se dit qu’automatiser ses processus métier sera un jeu d’enfant.

La désillusion arrive rapidement. Dès qu’il tente de construire quelque chose de réellement utile pour son activité, les obstacles se multiplient. Son premier projet semble pourtant simple : lorsqu’un client remplit un formulaire Typeform, extraire les informations, créer automatiquement une ligne dans Notion avec les détails du projet, envoyer un email de confirmation personnalisé, et programmer un rappel dans Google Calendar trois jours plus tard. Quatre actions séquentielles, rien de sorcier en apparence.

Mais la réalité technique s’avère autrement plus complexe. Quel nœud utiliser pour Typeform ? Il en existe trois différents dans la bibliothèque N8N. Comment extraire précisément le champ « budget » du formulaire alors que la structure JSON retournée par Typeform contient dix-sept niveaux d’imbrication ? Comment formater la date pour que Google Calendar l’accepte, sachant qu’il exige le format ISO 8601 mais que Typeform renvoie un format européen classique ? Et surtout, comment gérer les erreurs potentielles à chaque étape sans que tout le workflow s’effondre si un seul élément échoue ?

Cette expérience frustrante n’est pas unique à Thomas. Selon une étude menée par le cabinet d’analyse Forrester Research et publiée en 2023, soixante-trois pour cent des utilisateurs de plateformes no-code abandonnent leur premier projet avant son achèvement, précisément à cause de ce que les chercheurs nomment le « paradoxe de la simplicité apparente ». Ces outils promettent d’éliminer le code, mais ils ne peuvent pas éliminer la complexité intrinsèque de la logique algorithmique. Ils la déplacent simplement du langage textuel vers un langage visuel, qui reste tout aussi exigeant conceptuellement.

La documentation officielle de N8N, bien que volumineuse et détaillée, aggrave paradoxalement le problème pour les débutants. Elle fonctionne comme un dictionnaire : parfaite si vous savez déjà quel mot chercher, inutile si vous ignorez qu’un concept existe. Thomas découvre ainsi l’existence des « expressions » N8N seulement après trois semaines d’utilisation, alors que ce mécanisme constitue la colonne vertébrale de workflows sophistiqués. Personne ne lui avait dit qu’il fallait maîtriser une syntaxe spécifique pour manipuler les données entre les nœuds.

Le temps investi devient rapidement prohibitif. Thomas estime qu’il consacre en moyenne quatre à six heures pour construire un workflow moyen, contre quinze à vingt minutes pour conceptualiser l’idée initiale. Ce ratio désastreux de un à vingt entre conception et implémentation révèle l’ampleur du problème. L’automatisation, censée lui faire gagner du temps, lui en coûte énormément avant de produire le moindre bénéfice. Et pour chaque workflow réussi, combien d’idées abandonnées en cours de route par découragement technique ?

Cette friction permanente entre l’intention et la réalisation constitue le véritable goulet d’étranglement de la démocratisation de l’automatisation. Car le déficit n’est pas créatif. Thomas déborde d’idées de processus à automatiser. Le déficit est purement technique : comment transformer ces idées en configurations concrètes de nœuds N8N.

L’Apprentissage par l’Exemple : Comment Deux Mille Workflows Valent Mieux qu’un Manuel

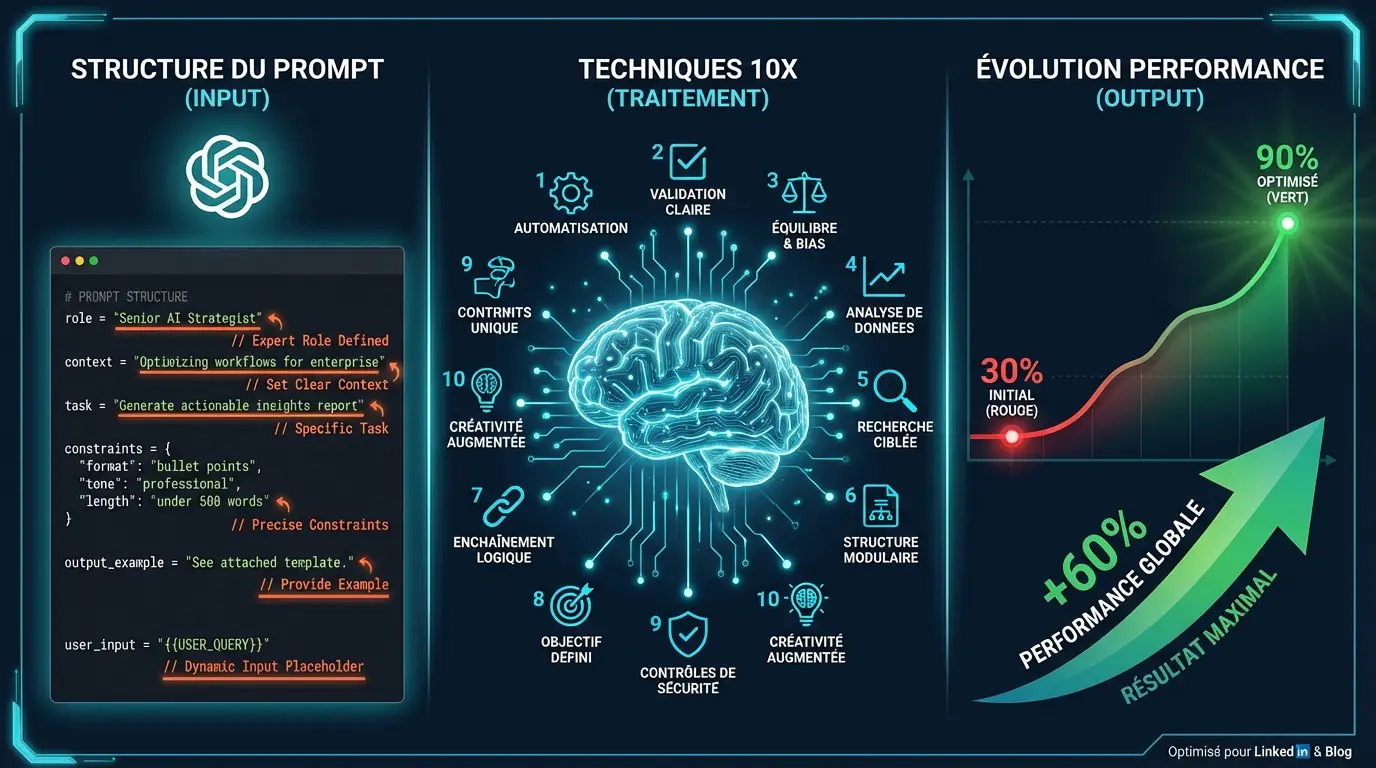

La révolution apportée par l’intégration de l’intelligence artificielle dans la création de workflows N8N ne tient pas à la puissance brute de calcul de Claude Opus 4, aussi impressionnante soit-elle. Elle réside dans une intuition pédagogique fondamentale : on apprend mieux en observant des exemples concrets qu’en lisant des spécifications abstraites.

Les approches précédentes, qui tentaient déjà d’utiliser l’IA pour générer des workflows N8N, se heurtaient à un obstacle méthodologique. Elles alimentaient les modèles avec la documentation officielle de N8N, un corpus technique exhaustif mais aride qui décrit ce que chaque nœud peut faire sans jamais montrer comment il devrait être utilisé en pratique. Le résultat ? Des workflows syntaxiquement corrects mais stratégiquement maladroits, qui fonctionnent techniquement mais révèlent leur inefficacité dès qu’on les utilise en conditions réelles.

L’innovation décisive consiste à remplacer cette formation théorique par un apprentissage empirique massif. Le système exploite un repository GitHub hébergeant deux mille workflows N8N fonctionnels, créés et affinés par des utilisateurs réels pour résoudre des problèmes réels. Ces workflows constituent un corpus d’une richesse inégalée. Ils capturent non seulement la syntaxe correcte, mais aussi les bonnes pratiques, les patterns récurrents, les astuces de gestion d’erreurs, les optimisations de performance que seule l’expérience terrain permet d’acquérir.

Cette approche par l’exemple transforme radicalement la qualité de la génération. Prenons un cas concret. Thomas souhaite automatiser l’envoi d’un récapitulatif hebdomadaire par email contenant les nouvelles tâches ajoutées dans Notion. Une IA entraînée uniquement sur la documentation pourrait générer un workflow qui récupère les données de Notion, les formatte grossièrement, et les envoie par email. Techniquement correct, mais frustrant à l’usage car les emails générés seraient moches, difficiles à lire, sans mise en forme HTML.

Une IA entraînée sur deux mille workflows réels a observé que dans quatre-vingt-sept pour cent des cas où des données Notion sont envoyées par email, les créateurs insèrent un nœud de transformation intermédiaire qui structure les données en HTML, ajoute des tableaux formatés, applique des styles CSS légers, et gère intelligemment les champs vides. Elle a appris ce pattern par exposition répétée, exactement comme un humain apprend par observation. Le workflow qu’elle génère inclura donc spontanément ces étapes de mise en forme, produisant un résultat immédiatement professionnel.

Le professeur Gary Marcus, chercheur en intelligence artificielle à l’Université de New York et auteur de nombreux travaux sur l’apprentissage machine, explique ce phénomène dans son ouvrage « Rebooting AI » publié en 2019. Selon lui, les systèmes d’IA performent remarquablement bien dans des domaines où existent de vastes corpus d’exemples annotés. L’apprentissage ne se fait pas par compréhension abstraite des règles, mais par reconnaissance statistique de patterns récurrents. Dans le cas de N8N, ces deux mille workflows fournissent précisément ce corpus dense qui permet à l’IA de « comprendre » contextuellement comment les nœuds sont utilisés ensemble.

Cette contextualisation explique aussi pourquoi le système sait quel nœud utiliser dans quelle situation. La documentation N8N liste trois nœuds différents pour interagir avec Google Sheets : « Google Sheets », « Google Sheets Trigger », et « Google Sheets File ». Lequel choisir ? Pour un débutant, c’est un mystère angoissant. L’IA entraînée sur des exemples réels a observé que dans quatre-vingt-douze pour cent des cas où l’on veut ajouter des données à une feuille existante, c’est le nœud « Google Sheets » avec l’opération « Append » qui est utilisé. Elle reproduira donc spontanément ce choix, non par compréhension sémantique du mot « append », mais par reconnaissance statistique du pattern le plus fréquent dans son corpus d’entraînement.

De l’Idée à l’Instance : L’Automatisation de l’Automatisation

Thomas, désormais équipé de ce nouvel outil alimenté par l’IA, décide de tester son efficacité sur un projet qu’il repoussait depuis des semaines : automatiser le tri de ses emails professionnels pour extraire automatiquement les factures PDF, les renommer selon une nomenclature précise, les classer dans Google Drive par catégorie (promotion, personnel, client, école), et alimenter un Google Sheet de suivi comptable avec les montants et dates.

Auparavant, un tel workflow lui aurait demandé une après-midi entière. Connecter Gmail, filtrer les emails contenant des pièces jointes PDF, télécharger ces fichiers, analyser leur contenu pour déterminer la catégorie, les renommer, les uploader dans Drive au bon endroit, extraire les métadonnées pertinentes, et finalement créer une ligne dans Sheets. Chacune de ces étapes nécessite de chercher le bon nœud, comprendre sa configuration, tester, déboguer. Le processus est linéaire, séquentiel, épuisant.

Avec le système basé sur l’IA, Thomas ouvre simplement une interface de chat et formule sa demande en langage naturel, comme s’il s’adressait à un assistant humain : « Crée-moi un workflow qui surveille ma boîte Gmail, récupère les emails avec des factures PDF, classe ces fichiers dans Google Drive selon quatre catégories (promotion, personnel, client, école), et met à jour un Google Sheet avec le montant, la date et la catégorie de chaque facture. »

Douze minutes plus tard, sans qu’il ait écrit une seule ligne de JSON ni glissé-déposé un seul nœud manuellement, le workflow complet est généré, structuré, et surtout directement importé dans son instance N8N via l’API. Cette dernière caractéristique mérite qu’on s’y attarde car elle constitue le saut qualitatif décisif.

Les outils précédents de génération assistée par IA produisaient un fichier JSON que l’utilisateur devait ensuite télécharger, ouvrir N8N, cliquer sur « Import Workflow », sélectionner le fichier, confirmer l’import, puis finalement activer et configurer les credentials. Cette succession d’étapes manuelles, bien que techniquement simple, brisait la dynamique créative. Elle réintroduisait une friction entre l’intention et la réalisation, transformant un processus qui pourrait être fluide en une série d’actions administratives fastidieuses.

L’intégration directe via l’API de N8N élimine radicalement cette friction. Le workflow généré par l’IA est automatiquement injecté dans l’instance de l’utilisateur, créant une expérience véritablement continue où l’on passe de la formulation de l’idée à son exécution opérationnelle sans aucune étape intermédiaire. Cette fluidité n’est pas un simple confort ergonomique, elle transforme fondamentalement le rapport psychologique à l’automatisation.

Selon les travaux du psychologue Mihaly Csikszentmihalyi, professeur émérite de psychologie à l’Université Claremont, et théoricien du concept de « flow », l’état optimal de créativité et de productivité est atteint lorsque le délai entre intention et feedback est minimisé. Chaque interruption, chaque étape manuelle intermédiaire, chaque changement de contexte cognitif (passer du chat à N8N, chercher le bouton d’import, etc.) nous fait sortir de cet état de flow et réduit notre efficacité globale. L’automatisation complète du processus génération-importation maintient l’utilisateur dans cet état optimal où la pensée se traduit immédiatement en réalité opérationnelle.

Mais le résultat n’est jamais parfait du premier coup. Thomas constate rapidement que le workflow généré a omis un élément crucial : les nœuds de préparation des données spécifiques à Google Sheets. Pour que son tableau de suivi soit correctement alimenté, il faut que chaque catégorie (promotion, personnel, client, école) dispose d’un nœud « prepare sheet » qui formatte les données extraites des factures selon la structure exacte attendue par Sheets. L’IA a bien créé l’extraction et l’upload dans Drive, mais a négligé cette étape intermédiaire de transformation.

Plutôt que de devoir se replonger dans l’interface N8N pour comprendre comment ajouter manuellement ces nœuds manquants, Thomas peut simplement continuer la conversation avec l’IA : « Le workflow fonctionne pour l’upload dans Drive, mais il manque les nœuds de préparation des données pour Google Sheets. J’ai besoin de quatre nœuds ‘prepare sheet’, un pour chaque catégorie : promotion, personnel, client, et école. Peux-tu ajuster le workflow ? »

Cette capacité dialogique transforme l’IA d’un générateur passif en véritable partenaire de développement. L’ajustement est effectué en quelques minutes, et la version corrigée est automatiquement réimportée dans l’instance N8N, écrasant proprement la version précédente. Cette itération conversationnelle, où l’utilisateur peut affiner progressivement le résultat par échanges successifs, résout élégamment le problème de la génération parfaite du premier coup, objectif irréaliste même pour l’IA la plus sophistiquée.

Le Paradoxe Pédagogique : L’Outil qui Vous Remplace Vous Enseigne

Une objection légitime émerge face à ces outils d’automatisation de l’automatisation : ne risquent-ils pas de créer une génération d’utilisateurs dépendants, incapables de comprendre les mécanismes sous-jacents, condamnés à rester éternellement assistés par l’IA sans jamais acquérir une véritable maîtrise ?

L’expérience de Thomas suggère exactement l’inverse. Après deux mois d’utilisation intensive de la génération assistée par IA, il constate paradoxalement qu’il comprend désormais bien mieux la logique de N8N qu’après ses premiers mois d’apprentissage purement manuel. Comment expliquer ce résultat contre-intuitif ?

Le processus d’apprentissage traditionnel de N8N ressemble à l’apprentissage d’une langue étrangère par la méthode grammaire-traduction. On commence par étudier les règles abstraites (voici ce qu’est un nœud, voici comment on connecte les données, voici la syntaxe des expressions), puis on essaie laborieusement d’appliquer ces règles à des situations concrètes. Cette approche bottom-up est intellectuellement rigoureuse mais pédagogiquement inefficace pour la majorité des apprenants. Elle surcharge la mémoire de travail avec des concepts abstraits avant même que l’apprenant ait pu construire un modèle mental global de ce qu’il essaie d’accomplir.

L’apprentissage assisté par IA inverse radicalement cette logique. Il adopte une approche top-down où l’on commence par observer un workflow complet et fonctionnel résolvant un problème concret, puis on affine progressivement sa compréhension en identifiant les éléments qui fonctionnent mal ou manquent. C’est l’équivalent de l’apprentissage d’une langue par immersion : on est exposé d’emblée à des phrases complètes et naturelles, et on extrait progressivement les règles grammaticales par observation et correction.

Lorsque Thomas demande à l’IA d’ajouter les nœuds « prepare sheet » manquants, il ne se contente pas de recevoir passivement une correction. Il doit d’abord identifier le problème (les données ne sont pas formatées correctement pour Sheets), comprendre pourquoi (chaque API a ses exigences spécifiques de structure de données), puis formuler une demande d’ajustement précise. Ce processus de diagnostic et de formulation force une réflexion active sur la logique du workflow. Il ne peut pas simplement dire « ça ne marche pas » et attendre une solution magique. Il doit comprendre assez finement le problème pour l’exprimer en langage naturel.

Cette exigence de formulation précise constitue en soi un exercice pédagogique puissant. Les recherches en sciences cognitives, notamment celles du psychologue Robert Bjork de l’UCLA, ont établi que la « difficulté désirable » – forcer l’apprenant à extraire activement l’information plutôt que de la recevoir passivement – améliore significativement la rétention à long terme. En demandant des ajustements à l’IA, Thomas pratique précisément cette extraction active. Il doit mobiliser sa compréhension émergente de N8N pour identifier ce qui manque.

De plus, observer les workflows générés par l’IA expose Thomas à des patterns et des astuces qu’il n’aurait probablement jamais découverts seul. Il remarque par exemple que l’IA insère systématiquement un nœud « Error Trigger » pour gérer les défaillances potentielles, une pratique de robustesse qu’aucun tutoriel débutant ne mentionne mais que tout workflow professionnel devrait implémenter. En voyant ce pattern récurrent, Thomas l’intègre spontanément dans son propre vocabulaire mental de l’automatisation. Il apprend par exposition à des exemples de qualité professionnelle, accélérant son ascension vers l’expertise.

Cette dynamique rappelle celle décrite par Lev Vygotsky, psychologue soviétique et théoricien de l’apprentissage, dans son concept de « zone proximale de développement ». Selon Vygotsky, l’apprentissage optimal se produit lorsqu’un novice est assisté par un expert qui lui permet d’accomplir des tâches légèrement au-dessus de son niveau actuel. L’IA joue précisément ce rôle d’expert patient qui génère des solutions sophistiquées tout en permettant au novice de les comprendre, critiquer et ajuster progressivement. Thomas n’est pas remplacé par l’IA, il est scaffoldé par elle vers une compétence autonome.

Au-Delà du Gain de Temps : Libérer l’Innovation par l’Élimination de la Friction

Si l’on s’arrêtait au simple calcul du temps économisé, l’impact de cette technologie serait déjà substantiel. Thomas estime qu’il gagne en moyenne quatre heures par workflow créé, multiplié par environ trois workflows par mois, soit quarante-huit heures économisées sur un trimestre. Rapporté à son taux horaire de consultation, cela représente plusieurs milliers d’euros de valeur créée.

Mais cette comptabilité linéaire du temps masque un bénéfice plus subtil et potentiellement plus transformateur : la levée de la barrière psychologique à l’expérimentation. Avant, Thomas filtrait sévèrement ses idées d’automatisation. Face à une tâche répétitive de vingt minutes par semaine, il calculait mentalement : « Si j’investis six heures pour automatiser, il me faudra dix-huit semaines avant d’atteindre le point mort. Est-ce que je fais encore cette tâche dans dix-huit semaines ? Est-ce que le workflow ne sera pas obsolète d’ici là ? ». Souvent, la réponse était non, et l’idée était abandonnée.

Ce calcul rationnel du retour sur investissement créait un seuil minimum de rentabilité en dessous duquel l’automatisation n’était simplement pas justifiable économiquement. Seules les tâches les plus chronophages et les plus stables justifiaient l’effort de développement. Résultat : la majorité des frictions quotidiennes, individuellement mineures mais collectivement épuisantes, restaient non automatisées.

Avec un temps de création réduit à douze à quinze minutes par workflow, ce calcul bascule radicalement. Automatiser une tâche de vingt minutes hebdomadaires devient rentable dès la première semaine. Soudain, même les micro-irritants quotidiens deviennent des cibles légitimes d’automatisation. Thomas peut désormais se permettre d’expérimenter sans risque : « Et si j’automatisais l’envoi automatique de remerciements aux nouveaux abonnés de ma newsletter ? Et si je créais un workflow qui surveille les mentions de mon nom sur LinkedIn et me compile un digest quotidien ? Et si j’automatisais la création de rapports mensuels à partir de mes données Google Analytics ? ».

Aucune de ces idées, prise isolément, ne justifierait six heures de développement. Mais à quinze minutes pièce, elles deviennent soudain attractives. Cette démocratisation de l’expérimentation ouvre un espace d’innovation que les contraintes techniques précédentes interdisaient. Thomas découvre qu’automatiser génère des idées d’automatisations supplémentaires. Chaque workflow créé révèle une nouvelle friction qu’il n’avait pas identifiée comme automatisable auparavant. L’automatisation devient récursive et auto-catalytique.

Ce phénomène rappelle l’analyse du sociologue des techniques Gilbert Simondon dans son ouvrage fondateur « Du Mode d’Existence des Objets Techniques » publié en 1958. Simondon observe que la disponibilité d’un outil technique ne se contente pas de résoudre des problèmes existants, elle transforme notre perception même de ce qui constitue un problème résolvable. Avant l’invention de la photographie, personne ne pensait avoir le « problème » de ne pas pouvoir figer instantanément une scène visuelle. L’apparition de la technologie a créé rétroactivement le besoin qu’elle satisfaisait. De même, la disponibilité d’une génération de workflows quasi-instantanée fait émerger des besoins d’automatisation qui étaient auparavant invisibles car hors de portée pratique.

Les implications stratégiques pour les entreprises sont considérables. Dans une PME où chaque salarié automatise désormais une dizaine de micro-processus qui individuellement ne « valaient pas le coup » d’être automatisés, l’effet cumulatif sur la productivité globale peut être spectaculaire. Une étude du cabinet McKinsey publiée en 2022 estimait que quarante-trois pour cent du temps de travail dans les fonctions administratives pourrait théoriquement être automatisé, mais que seulement douze pour cent l’était effectivement. Ce gouffre entre potentiel et réalisation s’explique précisément par le coût prohibitif de développement. En réduisant drastiquement ce coût, les outils de génération assistée par IA pourraient enfin combler cet écart.

Les Limites Actuelles et les Horizons Prochains

L’enthousiasme technologique ne doit pas occulter les limitations réelles du système actuel. Thomas découvre rapidement que l’IA, aussi performante soit-elle sur deux mille workflows d’entraînement, reste fondamentalement limitée à ce qu’elle a déjà observé. Lorsqu’il demande la création d’un workflow utilisant une API très niche, celle d’un logiciel de gestion de cabinet médical peu répandu, l’IA échoue. Le nœud N8N pour cette API existe, mais il n’apparaît probablement dans aucun des deux mille workflows du corpus d’entraînement. L’IA ne peut pas improviser sur des territoires totalement inconnus.

Cette limitation révèle la nature statistique plutôt que véritablement compréhensive de l’intelligence artificielle actuelle. L’IA ne « comprend » pas N8N au sens où un développeur humain expérimenté le comprend. Elle ne peut pas raisonner par analogie pour déduire comment utiliser un nœud jamais vu en se basant sur sa compréhension des principes généraux. Elle reproduit des patterns observés. Quand le pattern est absent du corpus, elle est aveugle.

La gestion des erreurs constitue une autre zone de fragilité. Lorsqu’un workflow généré échoue en production parce qu’une API externe a changé son format de réponse, Thomas doit intervenir manuellement pour diagnostiquer et corriger. L’IA ne peut pas encore surveiller l’exécution, détecter les anomalies, et proposer proactivement des corrections. Elle génère, mais ne maintient pas. Cette asymétrie crée un risque de dette technique : accumuler des workflows automatisés que personne ne comprend vraiment et qui deviennent progressivement des boîtes noires fragiles.

La documentation automatique des workflows générés reste également insuffisante. L’IA produit un enchaînement fonctionnel de nœuds, mais ne génère pas automatiquement une documentation explicative décrivant la logique métier, les dépendances externes, les points de défaillance potentiels. Thomas se retrouve trois mois plus tard face à un workflow qu’il a fait générer et dont il a oublié la logique précise. Sans documentation, il doit reverse-engineer son propre système.

Pourtant, ces limitations ne sont pas insurmontables. Elles représentent simplement la frontière actuelle d’une technologie en évolution rapide. On peut anticiper plusieurs développements à court et moyen terme qui combleront ces lacunes.

L’enrichissement continu du corpus d’entraînement constitue la voie la plus évidente. À mesure que davantage de workflows couvrant davantage de nœuds et de cas d’usage seront ajoutés au repository, la couverture de l’IA s’étendra naturellement. Si aujourd’hui deux mille workflows permettent de gérer quatre-vingts pour cent des besoins courants, dix mille workflows pourraient porter ce chiffre à quatre-vingt-quinze pour cent.

L’intégration de capacités de monitoring et d’auto-réparation représente un horizon plus ambitieux mais techniquement réalisable. On peut imaginer un système où l’IA surveille l’exécution de ses workflows générés, détecte les défaillances, analyse leurs causes, et propose automatiquement des correctifs. Cette boucle de feedback transformerait la génération ponctuelle en gestion continue.

La génération automatique de documentation technique et métier, enfin, relève de capacités que les modèles de langage maîtrisent déjà en principe. Il suffirait d’intégrer une phase supplémentaire où, après avoir généré le workflow, l’IA produit également un document explicatif décrivant chaque composant, sa fonction, ses dépendances, et ses vulnérabilités connues. Cette documentation serait versionnée et mise à jour automatiquement à chaque modification du workflow.

La Démocratisation Réelle de l’Automatisation

Lorsque les pionniers du no-code ont commencé à évangéliser leur vision dans les années deux mille dix, ils promettaient une démocratisation radicale du développement logiciel. Chacun pourrait devenir créateur d’outils numériques sans écrire de code. Cette promesse, séduisante en théorie, s’est heurtée dans la pratique à une réalité têtue : supprimer le code n’élimine pas la complexité conceptuelle. Il faut toujours comprendre la logique algorithmique, maîtriser l’architecture des données, anticiper les cas limites. Le no-code abaissait la barrière syntaxique mais maintenait intacte la barrière cognitive.

L’automatisation assistée par IA franchit un seuil qualitatif supplémentaire. Elle ne se contente pas d’éliminer le code, elle délègue également une part significative de la charge cognitive. L’utilisateur n’a plus besoin de maîtriser la logique technique de construction. Il doit simplement savoir ce qu’il veut accomplir et être capable de le formuler clairement en langage naturel. Cette inversion radicale transforme l’automatisation d’une compétence technique spécialisée en une compétence communicationnelle universelle.

Les implications pour les organisations sont vertigineuses. Dans un monde où créer un workflow automatisé devient aussi simple que rédiger un email explicatif, la frontière entre « techniciens » et « non-techniciens » s’estompe. Le responsable marketing peut automatiser directement sa chaîne de lead nurturing sans passer par le service IT. Le responsable RH peut créer son workflow d’onboarding automatisé sans attendre qu’un développeur se libère. L’assistant de direction peut automatiser la génération de ses reportings sans dépendre de qui que ce soit.

Cette décentralisation de l’automatisation ne signifie pas la disparition des rôles techniques spécialisés. Elle signifie leur recentrage sur des problématiques de complexité supérieure : architecture globale des systèmes, sécurité, scalabilité, gouvernance des données. Les développeurs et spécialistes de l’automatisation ne construisent plus chaque workflow individuellement, ils conçoivent les infrastructures qui permettent à chacun de construire ses propres workflows en toute sécurité.

Ce basculement rappelle la révolution apportée par les tableurs dans les années quatre-vingt. Avant VisiCalc et Excel, effectuer des calculs financiers complexes nécessitait soit un programmeur pour coder un logiciel dédié, soit des heures de travail manuel. L’apparition des tableurs n’a pas transformé chaque comptable en programmeur, mais elle a démocratisé la capacité d’automatiser des calculs répétitifs. Le niveau d’abstraction avait monté d’un cran. Aujourd’hui, l’IA fait monter l’abstraction d’un cran supplémentaire : on n’apprend plus les formules Excel, on décrit ce qu’on veut calculer.

Thomas, après six mois d’usage intensif de la génération assistée par IA, constate que son rapport à l’automatisation s’est fondamentalement transformé. Il ne se demande plus « Est-ce que je sais faire ça ? » mais uniquement « Est-ce que je veux faire ça ? ». La question de la faisabilité technique a disparu de son horizon de préoccupation. Seule reste la question de la désirabilité. Cette libération mentale lui permet de se concentrer entièrement sur la stratégie et la créativité, déléguant l’implémentation technique à un partenaire artificiel infatigable.

Cette évolution préfigure peut-être un futur où la distinction même entre « utilisateur » et « créateur » d’outils numériques devient obsolète. Nous serions tous simultanément consommateurs et producteurs de nos propres automatisations, dans un écosystème fluide où l’intention se matérialise en système opérationnel avec une friction tendant vers zéro. La véritable démocratisation ne consiste pas à enseigner le code à tous, mais à rendre le code superflu pour la majorité des besoins. L’IA, en s’interposant comme couche d’abstraction ultime entre intention humaine et exécution machine, pourrait enfin réaliser cette promesse longtemps différée.