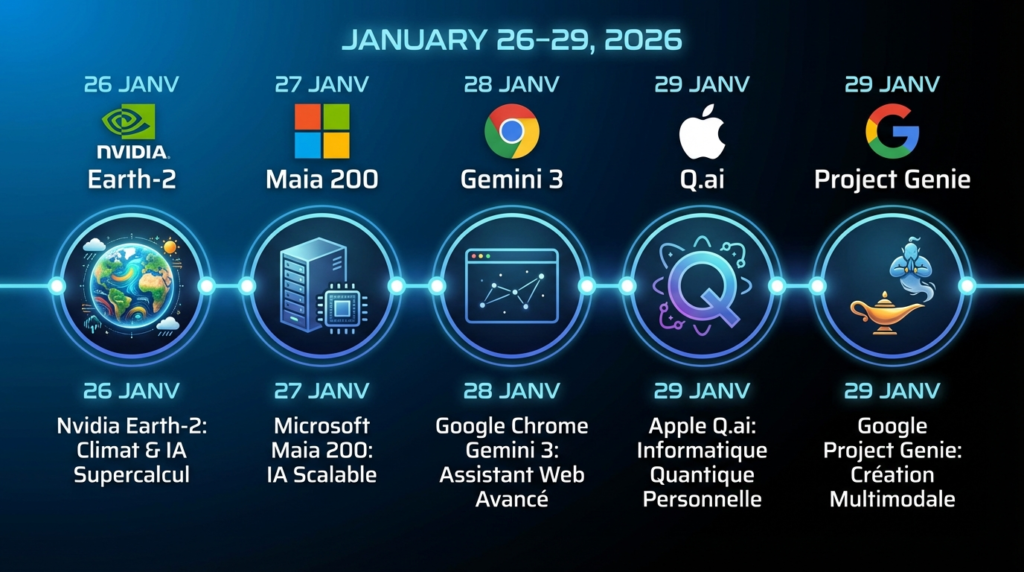

Janvier 2026 marque un tournant. Google crée des mondes 3D navigables par simple texte. Chrome devient un agent capable d’agir à votre place sur le web. OpenAI lance la publicité conversationnelle à 60 $ le CPM. Microsoft dévoile une puce d’inférence trois fois plus rapide que la concurrence. Apple investit 2 milliards dans la communication silencieuse. Et Nvidia prédit la météo mondiale en quelques secondes. L’IA n’assiste plus. Elle exécute. Décryptage d’une semaine qui redessine les règles du jeu.

Il y a des semaines qui comptent. Celle du 26 janvier 2026 en fait partie. En cinq jours, Google, Microsoft, Apple, OpenAI et Nvidia ont chacun posé une pierre fondatrice. Pas un communiqué de plus. Pas une promesse de laboratoire. Des produits. Des puces. Des acquisitions. Des prix.

Le paradigme bascule. Les IA agents autonomes ne sont plus une abstraction de chercheur. Ils naviguent le web. Ils génèrent des environnements tridimensionnels. Ils prévoient le climat. Ils achètent à votre place. Et ils vendent de l’attention publicitaire au prix du luxe.

Pourtant, la majorité des décideurs n’ont pas encore pris la mesure de ce virage. Cet article décode chaque rupture, vérifie les faits, et vous donne les clés pour agir.

L’essentiel — En janvier 2026, l’intelligence artificielle franchit un seuil opérationnel décisif. Google transforme du texte en mondes 3D explorables. Chrome exécute des tâches complexes à la place de l’utilisateur. OpenAI introduit la publicité dans ChatGPT à un tarif trois fois supérieur à Meta. Microsoft et Apple investissent massivement dans l’indépendance matérielle. L’ère des IA agents autonomes ne commence pas demain. Elle a déjà commencé.

Les IA agents autonomes désignent des systèmes d’intelligence artificielle capables d’exécuter des séquences d’actions complexes sans intervention humaine continue. Contrairement aux assistants conversationnels classiques, ces agents interagissent directement avec les interfaces, les données et les environnements numériques pour accomplir des objectifs définis par l’utilisateur.

Google Genie : quand l’IA crée des mondes

Certaines annonces changent la perception d’une technologie. Project Genie fait partie de celles-là. Le 29 janvier 2026, Google a ouvert l’accès à un prototype capable de transformer du texte en environnement 3D navigable en temps réel. Ce n’est pas un jeu vidéo. Ce n’est pas un rendu statique. C’est un monde génératif.

Du texte au monde en 60 secondes

Le mécanisme est aussi simple que vertigineux. L’utilisateur décrit un environnement. Il choisit un personnage. L’IA génère une image d’aperçu via Nano Banana Pro. Puis Genie 3, le modèle de monde développé par Google DeepMind, transforme cette image en espace explorable.

L’exploration se fait en temps réel. Entre 20 et 24 images par seconde. En résolution 720p. L’environnement se construit au fur et à mesure du déplacement de la caméra. Chaque pas génère le monde qui se trouve devant.

En effet, la cohérence spatiale constitue la vraie prouesse. Si l’utilisateur revient sur ses pas, le monde reste intact. Les modifications persistent. Genie 3 fonctionne de manière autorégressive : chaque image est produite en tenant compte de l’historique complet des images précédentes et des actions de l’utilisateur.

Néanmoins, l’accès reste élitiste. Le prototype est réservé aux abonnés Google AI Ultra aux États-Unis. Le tarif : 250 dollars par mois. Ce prix traduit une réalité computationnelle brute. Générer un monde en temps réel coûte cher.

Les limites révélatrices d’un prototype

La durée d’exploration est plafonnée à 60 secondes. La physique souffre d’aberrations. Le texte généré dans les environnements reste souvent illisible. Les interactions entre agents multiples échouent encore.

Toutefois, ces limites ne doivent pas masquer l’essentiel. Pour la première fois, une IA comprend suffisamment la tridimensionnalité pour générer un monde cohérent à la volée. La trajectoire est claire. Dans notre pratique d’accompagnement de PME et d’architectes, nous observons déjà des cas d’usage concrets : prévisualisation de scènes, prototypage spatial, exploration de concepts architecturaux.

Dès lors, Genie ne concerne pas uniquement le jeu vidéo. Il annonce un futur où la barrière entre intention créative et réalité virtuelle s’efface progressivement. Google étend désormais cette logique agentique au cœur de son navigateur.

Le moteur de jeu instantané n’est plus une fiction. C’est un prototype à 250 dollars par mois.

Chrome devient un agent IA

Le navigateur le plus utilisé au monde vient de changer de nature. Le 28 janvier 2026, Google a annoncé l’intégration de Gemini 3 directement dans Chrome, avec une fonctionnalité qui redéfinit la navigation : Auto Browse.

Auto Browse et la fin du clic

Le principe rompt avec tout ce que nous connaissions du navigateur. L’utilisateur formule une demande en langage naturel. L’IA prend le contrôle. Elle navigue entre les pages. Elle compare les options. Elle remplit des formulaires. Elle applique des promotions.

Par exemple, un utilisateur peut demander à Gemini de planifier un voyage. L’agent parcourt alors les sites de compagnies aériennes, compare les tarifs sur plusieurs dates, et synthétise les résultats dans un itinéraire unique. Le tout sans que l’utilisateur ne clique une seule fois.

Comme le détaille le blog officiel de Google, cette fonctionnalité est disponible pour les abonnés AI Pro et AI Ultra aux États-Unis. L’IA s’arrête automatiquement avant toute action sensible : achat, publication sur les réseaux sociaux, ou saisie de données financières. L’utilisateur reste maître de la validation finale.

Par ailleurs, Chrome intègre désormais un panneau latéral permanent dédié à Gemini. Le chatbot devient un compagnon de navigation constant. Il analyse simultanément plusieurs onglets, compare les informations, et synthétise les résultats.

Le commerce universel piloté par l’IA

L’annonce la plus stratégique concerne peut-être le Universal Commerce Protocol (UCP). Ce nouveau standard ouvert, co-développé avec Shopify, Etsy, Wayfair et Target, permet aux agents IA d’agir au nom de l’utilisateur dans les environnements commerciaux.

Autrement dit, Chrome ne se contente plus d’afficher des pages web. Il les comprend. Il interagit avec le DOM. Il remplit les champs. Il ajoute au panier. Il négocie presque. Cette évolution illustre parfaitement la transformation des métiers par l’IA que nous analysions récemment.

En somme, le navigateur n’est plus une fenêtre. C’est un employé numérique.

L’écosystème Claude face à la commoditisation

Pendant que Google déploie son intégration verticale, Anthropic poursuit sa stratégie communautaire. Avec des tensions révélatrices.

OpenClaw et la tension communautaire

L’histoire d’OpenClaw résume un paradoxe de l’IA open source. Ce projet communautaire permet de faire tourner un assistant autonome en local. Initialement baptisé Claudebot, il a dû changer de nom sous la pression d’Anthropic. Puis Moltbot. Puis OpenClaw.

Au-delà du rebranding, l’enjeu est la sécurité. Les utilisateurs exécutent des agents capables de contrôler leur machine principale. La tension entre autonomie et risque de compromission reste permanente.

Cependant, cette effervescence communautaire prouve la vitalité de l’écosystème. L’IA agentique attire les développeurs précisément parce qu’elle promet l’exécution, pas seulement la conversation.

MCP, Excel et les promesses du terrain

Claude étend ses capacités via le protocole MCP (Model Context Protocol). Les connexions avec Slack, Figma ou Asana se multiplient. L’arrivée de Claude dans Excel permet de générer des données massives directement dans les cellules.

Or, un écart persiste entre la promesse et la réalité. Lors de tests d’intégration avec Figma, les modèles peuvent s’enfermer dans des boucles d’erreurs. Le retour aux méthodes manuelles reste parfois inévitable.

De plus, ces fonctionnalités subissent une commoditisation rapide. Microsoft Copilot propose déjà des services similaires. La différenciation par la seule intégration logicielle devient insuffisante. Comme nous l’avions analysé dans notre article sur la sécurité IA en entreprise, la fiabilité reste le critère décisif.

L’agenticité logicielle progresse. Sa fiabilité industrielle, elle, doit encore mûrir.

ChatGPT vend de l’attention à 60 $ le CPM

Le 2 février 2026, OpenAI a franchi une étape symbolique. La publicité est officiellement entrée dans ChatGPT.

Le pari de l’intention conversationnelle

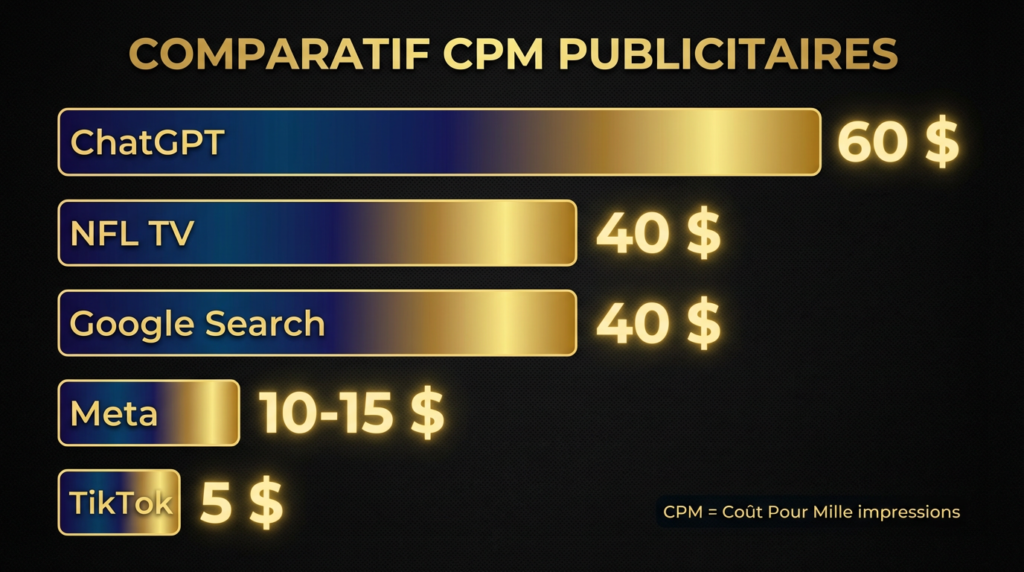

Le positionnement tarifaire a surpris l’ensemble du marché. OpenAI demande environ 60 dollars pour mille impressions (CPM). Ce tarif situe ChatGPT au niveau des retransmissions sportives premium, loin au-dessus des standards des plateformes sociales.

À titre de comparaison, les CPM observés chez Meta oscillent entre 8 et 15 dollars. TikTok et YouTube se situent entre 4 et 6 dollars. Même la télévision traditionnelle plafonne entre 27 et 40 dollars. OpenAI se positionne donc 50 % au-dessus du haut de gamme télévisuel.

En réalité, ce tarif repose sur un argument précis : la valeur de l’intention. Quand un utilisateur interroge ChatGPT, il révèle une intention brute et non filtrée. Il compare. Il hésite. Il n’a pas encore tranché. Pour un annonceur, apparaître à ce moment exact représente une opportunité rare.

Selon The Information, le ticket d’entrée minimum s’élève à 200 000 dollars pour la phase bêta. Les publicités n’apparaissent que sur les versions gratuites et Go aux États-Unis. Les abonnés Plus, Pro, Business et Enterprise conservent une expérience sans publicité.

Un modèle qui divise l’industrie

Le modèle suscite un scepticisme légitime. OpenAI ne propose aucun suivi de conversion. Pas de coût par clic. Pas d’attribution granulaire. En 2026, cette approche tranche radicalement avec les pratiques établies par Google Ads ou Meta Business Suite.

Néanmoins, la stratégie est cohérente. Sam Altman a décrit un modèle économique multifacettes dans un billet de janvier 2026 : abonnements, API, publicité, commerce, et potentiellement revente de capacité de calcul. La publicité cible spécifiquement les 95 % d’utilisateurs qui ne paient pas d’abonnement. Avec plus de 800 millions d’utilisateurs hebdomadaires, le potentiel reste considérable.

C’est pourquoi la vraie bataille ne sera pas le CPM. Ce sera la perception. L’utilisateur ressentira-t-il une recommandation utile ou une réponse sponsorisée déguisée ? Cette question rejoint les enjeux que nous avions explorés dans notre analyse de la géopolitique de l’IA.

La pub dans un assistant conversationnel n’est pas une pub dans un fil d’actualité. OpenAI joue son capital confiance.

La guerre des puces d’inférence

Derrière les interfaces, une bataille matérielle redéfinit les rapports de force. L’enjeu : réduire la dépendance à Nvidia.

Maia 200 : Microsoft joue l’indépendance

Le 26 janvier 2026, Microsoft a dévoilé le Maia 200. Cet accélérateur d’inférence, fabriqué par TSMC en technologie 3 nanomètres, affiche des caractéristiques impressionnantes. Plus de 10 pétaflops en précision FP4. 216 Go de mémoire HBM3e. Une bande passante de 7 téraoctets par seconde.

En termes concrets, un seul nœud Maia 200 peut exécuter les plus grands modèles actuels. Selon TechCrunch, cette puce délivre trois fois les performances FP4 du Trainium3 d’Amazon et dépasse le TPU v7 de Google en FP8.

Par conséquent, Microsoft rejoint la stratégie d’intégration verticale de Google (TPU) et d’Amazon (Trainium). L’objectif est double. Réduire la dépendance critique envers Nvidia. Optimiser les coûts d’inférence à grande échelle.

Scott Guthrie, vice-président exécutif de Microsoft, résume l’ambition : le Maia 200 offre 30 % de performances supplémentaires par dollar dépensé. Sa consommation de 750 watts reste inférieure aux GPU Nvidia, qui dépassent souvent les 1 200 watts.

Toutefois, le Maia 200 reste une puce d’inférence pure. Elle ne remplace pas les GPU pour l’entraînement. La dépendance à Nvidia sur ce segment persiste. Cette nuance est essentielle. Comme nous l’avions documenté dans notre article sur TSMC et la fragilité des chaînes d’approvisionnement, la souveraineté matérielle reste le nerf de la guerre.

Apple rachète le silence pour 2 milliards

Le même jour, Apple a confirmé l’acquisition de Q.ai, une startup israélienne spécialisée dans l’analyse des micro-expressions faciales. Montant rapporté par le Financial Times : près de 2 milliards de dollars. La deuxième plus grande acquisition d’Apple après Beats en 2014.

Q.ai développe une technologie de « communication silencieuse ». Ses brevets décrivent des usages dans des casques ou lunettes utilisant les « micro-mouvements de la peau du visage » pour interagir sans parler. À terme, cela pourrait permettre de commander un appareil par simple mouvement labial.

Le fondateur de Q.ai, Aviad Maizels, avait déjà vendu PrimeSense à Apple en 2013. Cette technologie avait contribué au développement de la reconnaissance faciale d’Apple. L’histoire se répète.

Certes, Apple reste silencieux sur ses plans précis. Mais les implications sont claires. La convergence entre IA, objets connectés et interfaces non verbales dessine un futur où la technologie comprend notre corps avant nos mots.

L’acquisition la plus discrète de la semaine est peut-être la plus révolutionnaire.

L’IA au service de la Terre

L’intelligence artificielle ne transforme pas uniquement les interfaces numériques. Elle redéfinit notre compréhension du monde physique.

Nvidia Earth-2 et la prévision en secondes

Le 26 janvier 2026, à la réunion annuelle de l’American Meteorological Society, Nvidia a dévoilé Earth-2. Cette famille de modèles ouverts constitue la première pile logicielle complète et accélérée pour la prévision météorologique par IA.

Selon Bloomberg, Earth-2 comprend deux modèles principaux. Earth-2 Medium Range, propulsé par l’architecture Atlas, produit des prévisions à 15 jours sur plus de 70 variables atmosphériques. Earth-2 Nowcasting, basé sur StormScope, génère des prévisions locales de tempêtes à l’échelle du kilomètre sur un horizon de six heures.

En effet, la rupture réside dans la vitesse. Les modèles traditionnels de prévision numérique nécessitent des heures de calcul sur des supercalculateurs. Earth-2 Global Data Assimilation produit les conditions atmosphériques initiales en quelques secondes sur des GPU.

Quand le calcul remplace le supercalculateur

La démocratisation est l’autre dimension majeure. En rendant ces modèles open source, disponibles sur Hugging Face et GitHub, Nvidia permet à des organisations de taille modeste de déployer des systèmes de prévision comparables à ceux des grandes agences nationales.

Par ailleurs, les applications dépassent largement la météorologie. TotalEnergies, Eni et S&P Global utilisent déjà Earth-2 pour la gestion des risques énergétiques. Le service météorologique israélien déploie CorrDiff pour des prévisions haute résolution.

Ainsi, l’IA météorologique illustre un phénomène plus large. La puissance de calcul autrefois réservée à quelques institutions devient accessible. Le coût de l’intelligence chute. Et avec lui, la barrière d’entrée pour comprendre le monde.

La prévision météo n’est qu’un début. La simulation du réel par l’IA touche désormais tous les domaines.

Ce que ces ruptures signifient pour votre stratégie

Le chemin parcouru en quatre ans donne le vertige. De simples générateurs de texte, nous sommes passés à des systèmes capables de simuler la physique, d’agir sur le web, et de prévoir le climat.

Trois enseignements émergent de cette semaine de janvier 2026. D’abord, l’IA ne se contente plus d’assister. Elle exécute. Le passage d’un modèle conversationnel à un modèle agentique change la nature même de la relation homme-machine. Ensuite, l’infrastructure devient un avantage concurrentiel décisif. Ceux qui maîtrisent le silicium maîtrisent le coût de l’intelligence. Enfin, la confiance devient le nouveau terrain de bataille. Qu’il s’agisse de publicité dans ChatGPT ou d’agents qui naviguent à notre place, la question n’est plus technique. Elle est humaine.

Pour les dirigeants, les architectes, les designers et les entrepreneurs, le message est clair. L’IA n’est plus une option logicielle. Elle devient le système d’exploitation de notre réalité, physique et numérique. L’ignorer, c’est choisir l’obsolescence. L’adopter intelligemment, c’est prendre une longueur d’avance.

Chez Baair, nous accompagnons cette transition depuis ses prémices. La technologie sans vision reste un outil. La vision sans technologie reste un rêve. L’art est dans leur convergence.

L’IA ne remplacera pas ceux qui la comprennent. Elle remplacera ceux qui refusent de la voir.

FAQ

1. Qu’est-ce qu’un agent IA autonome ?

Un agent IA autonome est un système d’intelligence artificielle capable d’exécuter des séquences de tâches complexes sans intervention humaine continue. Contrairement à un chatbot classique qui répond à des questions, un agent navigue sur le web, remplit des formulaires, compare des offres et agit au nom de l’utilisateur. Chrome Auto Browse et Claude Code illustrent cette nouvelle génération d’IA agents autonomes qui transforment la productivité professionnelle.

2. Comment fonctionne Google Project Genie ?

Google Project Genie transforme du texte ou une image en un monde 3D navigable en temps réel. Propulsé par le modèle Genie 3 de DeepMind, il génère l’environnement de manière autorégressive à mesure que l’utilisateur se déplace. La résolution atteint 720p à 24 images par seconde. L’exploration est limitée à 60 secondes. L’accès nécessite un abonnement Google AI Ultra à 250 dollars par mois, uniquement disponible aux États-Unis.

3. Combien coûte la publicité dans ChatGPT ?

OpenAI facture environ 60 dollars pour 1 000 impressions (CPM) dans ChatGPT. Ce tarif positionne la plateforme trois à sept fois au-dessus de Meta et Snapchat. Le ticket d’entrée minimum est de 200 000 dollars pour la phase bêta. Les publicités n’apparaissent que sur les versions gratuites et Go. Les abonnés payants conservent une expérience sans publicité.

4. Qu’est-ce que le Maia 200 de Microsoft ?

Le Maia 200 est un accélérateur d’inférence IA conçu par Microsoft, fabriqué en technologie 3 nanomètres par TSMC. Il délivre plus de 10 pétaflops en précision FP4 et intègre 216 Go de mémoire HBM3e. Cette puce vise à réduire la dépendance de Microsoft envers Nvidia pour l’inférence de modèles IA à grande échelle sur Azure.

5. Pourquoi Apple a-t-elle racheté Q.ai pour 2 milliards ?

Apple a acquis Q.ai pour développer des interfaces de communication non verbale. La startup israélienne possède des brevets sur l’interprétation des micro-mouvements faciaux et de la parole silencieuse. Cette technologie pourrait permettre de commander Siri ou des objets connectés sans parler à voix haute, en utilisant uniquement les mouvements du visage.

6. Comment Nvidia Earth-2 transforme-t-il la prévision météo ?

Nvidia Earth-2 est une famille de modèles IA open source qui accélère toutes les étapes de la prévision météorologique. Le modèle Medium Range produit des prévisions à 15 jours sur plus de 70 variables atmosphériques. Le modèle Nowcasting génère des prévisions de tempêtes locales en quelques minutes. Ces outils fonctionnent en secondes sur GPU, contre des heures sur supercalculateurs traditionnels.