Jensen Huang, PDG de NVIDIA, explique pourquoi l’IA n’est pas un cycle logiciel mais l’industrialisation de l’intelligence. Contrairement au logiciel traditionnel qui est statique et prévisible, l’IA génère chaque réponse en temps réel, nécessitant une infrastructure GPU permanente comparable à un réseau électrique. Cette vision explique pourquoi les critiques sur la « bulle IA » passent à côté de l’essentiel : on ne juge pas une révolution industrielle sur ses revenus trimestriels, mais sur la dépendance croissante du monde à son infrastructure.

Lorsque Jensen Huang, PDG de NVIDIA, prend la parole pour expliquer la différence fondamentale entre l’intelligence artificielle et le logiciel traditionnel, il ne fait pas de la promotion pour ses GPU. Il reformule la nature même de la révolution technologique en cours. Pendant que les critiques répètent mécaniquement que « les revenus de l’IA ne sont pas encore là » ou que « les valorisations n’ont aucun sens », Huang propose une analogie qui bouleverse le débat : l’IA n’est pas un nouveau cycle logiciel, c’est l’industrialisation de l’intelligence. Et les révolutions industrielles ne se mesurent pas aux flux de trésorerie du premier trimestre, mais à la dépendance croissante du monde à leur égard. Cette distinction, apparemment simple, explique pourquoi NVIDIA a explosé en valeur, pourquoi les infrastructures GPU deviennent aussi critiques que les centrales électriques, et pourquoi le discours sur la « bulle IA » passe complètement à côté de l’essentiel.

La Thèse de Jensen Huang : L’IA comme Révolution Industrielle

Une Distinction Fondamentale que Personne ne Comprend

La citation de Huang résume tout : « L’IA n’est pas un autre cycle logiciel. C’est l’industrialisation de l’intelligence. Et les révolutions industrielles ne se déploient pas en bulles, elles redéfinissent l’économie. »

Cette affirmation n’est pas une hyperbole marketing. Elle repose sur une analyse structurelle de ce qui distingue l’IA du logiciel classique, et c’est cette distinction que la majorité des analystes financiers et des commentateurs technologiques échouent systématiquement à saisir.

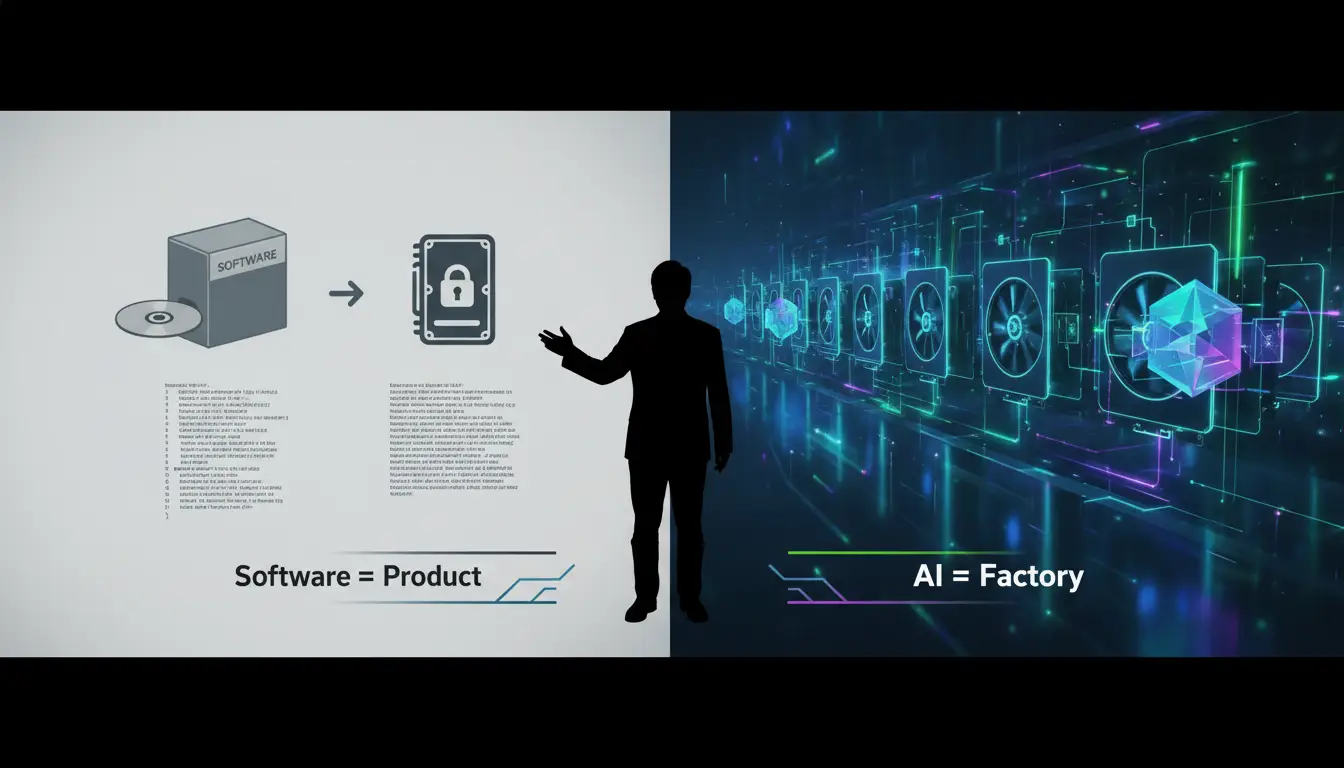

Le logiciel traditionnel est un produit fini. Vous écrivez le code, vous le compilez une fois, vous l’expédiez, et les utilisateurs l’exécutent. Une fois développé, il ne nécessite aucune puissance de calcul continue au-delà de l’exécution locale. Il est statique, prévisible et économiquement peu coûteux à opérer à grande échelle. Pensez à Microsoft Word, à Photoshop ou à n’importe quelle application traditionnelle : une fois installée, elle fonctionne sans consommer de ressources centralisées massives.

L’intelligence artificielle, elle, fonctionne exactement à l’inverse. Elle ne stocke pas de réponses préfabriquées. Elle génère chaque réponse, chaque paragraphe, chaque image, chaque décision en temps réel, à partir de zéro, à chaque requête. Chaque interaction nécessite une fabrication instantanée d’intelligence par des calculs intensifs. C’est une usine qui doit reconstruire le produit à chaque commande, plutôt qu’un entrepôt qui distribue des produits déjà fabriqués.

L’Analogie de l’Usine qui Change Tout

Pour comprendre cette différence fondamentale, Huang propose une métaphore éclairante. Le logiciel traditionnel est comme une usine qui a déjà fabriqué le produit. Vous cliquez sur l’icône, et le programme vous livre quelque chose de déjà construit. Mais l’IA ? L’IA est une usine qui doit fabriquer le produit chaque fois que vous lui demandez quelque chose.

Chaque réponse que génère ChatGPT, chaque image produite par Midjourney, chaque analyse effectuée par un agent IA nécessite des millions, voire des milliards d’opérations mathématiques instantanées. Ce n’est pas de l’exécution de code préexistant. C’est de la génération pure, de la création à la volée, de l’intelligence manufacturée en temps réel.

Cette distinction explique pourquoi la consommation énergétique et la demande en puissance de calcul ne diminuent jamais dans l’économie de l’IA. Au contraire, elles augmentent proportionnellement à l’usage.

La Dynamique Économique Unique de l’IA

L’Effet de Réseau Inversé : Plus d’Utilisateurs = Plus de Puissance

Dans le logiciel traditionnel, la croissance des utilisateurs n’augmente pas la consommation de ressources de manière significative. Un million d’utilisateurs supplémentaires de Microsoft Excel n’obligent pas Microsoft à installer un million de serveurs supplémentaires. Le logiciel scale horizontalement avec un coût marginal presque nul.

L’IA, elle, présente une dynamique radicalement différente que Huang résume ainsi : « Plus les gens utilisent l’IA, plus vous générez d’intelligence, plus vous avez besoin de GPU. Ce n’est pas un coût ponctuel, c’est une production continue. »

Concrètement, chaque utilisateur supplémentaire qui interagit avec un modèle IA génère une demande constante de puissance de calcul. Plus ChatGPT devient populaire, plus OpenAI doit disposer de GPU fonctionnant en permanence. Plus les entreprises déploient des agents IA pour automatiser leurs processus, plus elles consomment de ressources GPU.

Cette mécanique crée un besoin structurel, permanent et croissant en infrastructure de calcul. C’est ce que Huang appelle une infrastructure « always-on » (toujours active) et massive.

Les Trois Piliers de la Demande Permanente

Cette demande structurelle repose sur trois caractéristiques fondamentales de l’IA que Huang articule clairement.

Premier pilier : la puissance de calcul constante. Contrairement au développement logiciel traditionnel où la puissance de calcul n’est nécessaire qu’au moment du développement, l’IA nécessite une puissance de calcul constante pour chaque requête utilisateur, à perpétuité.

Deuxième pilier : la puissance GPU continue. Les GPU ne sont pas utilisés une fois lors du développement puis mis au repos. Ils tournent en permanence, traitant des millions de requêtes simultanées, générant de l’intelligence à la demande.

Troisième pilier : l’infrastructure massive et toujours active. Pensez aux data centers de Google, d’OpenAI, de Microsoft. Ces installations ne sont pas des bureaux de développement. Ce sont des usines de production d’intelligence qui fonctionnent 24 heures sur 24, 7 jours sur 7, sans interruption.

Cette triade transforme l’économie de l’IA en quelque chose qui ressemble davantage à l’industrie lourde qu’à l’industrie du logiciel.

Pourquoi les Critiques de la « Bulle IA » Passent à Côté du Point

L’Erreur de Mesure : Confondre Chiffre d’Affaires Immédiat et Infrastructure Fondamentale

Les sceptiques de l’IA répètent inlassablement le même argument : « Les revenus de l’IA ne sont pas encore là. Les valorisations n’ont aucun sens. » Cette critique révèle une incompréhension fondamentale de ce qui est en train de se construire.

On ne juge pas une centrale électrique ou un réseau d’infrastructures énergétiques sur la base du chiffre d’affaires du premier trimestre. On les évalue sur la dépendance croissante de l’économie à leur égard. Huang l’exprime clairement : « Vous ne jugez pas les centrales électriques ou les data centers sur la base de leur flux de trésorerie trimestriel. Vous les jugez sur la dépendance croissante du monde à leur égard. »

Or, cette dépendance croît exponentiellement. Chaque nouvelle application IA, chaque nouveau workflow automatisé, chaque assistant virtuel déployé dans une entreprise accroît la dépendance structurelle à l’infrastructure GPU. Peu importe que les revenus directs ne soient pas encore proportionnels aux investissements. Ce qui compte, c’est que l’infrastructure devient progressivement aussi indispensable que l’électricité.

L’Analogie avec l’Électricité : NVIDIA comme Nouveau Réseau Électrique

Huang pousse l’analogie encore plus loin : « La puissance de calcul de l’IA devient la nouvelle électricité. » Cette comparaison n’est pas métaphorique. Elle est littérale.

Au début du XXe siècle, lorsque les réseaux électriques ont été déployés, ils n’ont pas généré de revenus massifs immédiats. Les premiers utilisateurs étaient limités. Les applications concrètes de l’électricité étaient encore balbutiantes. Pourtant, ceux qui ont construit ces infrastructures — General Electric, Westinghouse, et d’autres — ont bâti des empires qui ont façonné l’économie mondiale pendant un siècle.

L’infrastructure GPU de NVIDIA suit exactement la même trajectoire. Aujourd’hui, elle alimente les modèles IA de pointe. Demain, elle alimentera chaque processus métier automatisé, chaque système de décision assistée par IA, chaque interaction client personnalisée. Peu importe que le modèle économique final ne soit pas encore totalement stabilisé. Ce qui compte, c’est que sans cette infrastructure, aucune de ces applications n’existera.

Les Implications Stratégiques pour les Entreprises

Repenser l’Investissement Technologique

Pour les dirigeants, architectes et entrepreneurs qui lisent ces lignes, la vision de Huang impose une réévaluation radicale de la façon dont on investit dans la technologie.

Si l’IA est effectivement une infrastructure comparable à l’électricité, alors l’investissement dans les capacités IA ne doit pas être traité comme un projet logiciel classique avec un ROI court terme. Il doit être traité comme un investissement infrastructurel stratégique dont la valeur se déploie sur des années, voire des décennies.

Cela signifie plusieurs choses concrètement. Premièrement, les entreprises ne peuvent plus attendre que l’IA « prouve sa rentabilité » avant d’investir. Celles qui attendent seront structurellement désavantagées face à celles qui construisent dès maintenant leur capacité de calcul IA.

Deuxièmement, l’accès à la puissance de calcul devient un avantage concurrentiel stratégique. Les entreprises qui sécurisent aujourd’hui leur accès à des infrastructures GPU — que ce soit via des partenariats cloud, des investissements directs ou des déploiements on-premise — se positionnent comme les futurs leaders de leurs secteurs.

Troisièmement, le coût de l’IA doit être repensé non pas comme une dépense, mais comme un coût de production permanent, similaire aux coûts énergétiques d’une usine. Une entreprise qui déploie des agents IA pour automatiser sa relation client ne fait pas un achat logiciel ponctuel. Elle met en place une infrastructure de production d’intelligence qui génèrera des coûts récurrents mais aussi des gains de productivité exponentiels.

Les Cas d’Usage qui Deviennent Incontournables

Cette nouvelle économie de l’IA déverrouille des applications qui n’auraient jamais été rentables dans un modèle logiciel traditionnel.

L’assistance en temps réel personnalisée devient viable. Plutôt que de concevoir des FAQ statiques ou des chatbots à script, les entreprises peuvent déployer des agents IA capables de comprendre le contexte spécifique de chaque client et de générer des réponses sur mesure instantanément.

L’automatisation intelligente des workflows complexes devient praticable. Des tâches qui nécessitaient auparavant une intervention humaine qualifiée — analyse de documents juridiques, conception architecturale préliminaire, diagnostic technique — peuvent être partiellement ou totalement automatisées grâce à des agents IA qui génèrent de l’intelligence contextuelle à la demande.

La création de contenu à grande échelle devient accessible. Que ce soit pour des rendus architecturaux, des campagnes marketing personnalisées ou des rapports analytiques, la capacité de générer du contenu de haute qualité en temps réel transforme radicalement l’économie de la production créative et intellectuelle.

Toutes ces applications partagent une caractéristique commune : elles nécessitent une infrastructure GPU permanente et robuste. C’est exactement ce que NVIDIA et les hyperscalers (AWS, Azure, Google Cloud) construisent en ce moment.

Les Risques et Limites d’une Infrastructure Centralisée

La Dépendance Stratégique aux Fournisseurs GPU

Cette transformation n’est pas sans risques. En devenant l’électricité du monde numérique, l’infrastructure GPU crée également une dépendance stratégique majeure envers un nombre limité de fournisseurs.

NVIDIA détient aujourd’hui une position quasi-monopolistique sur le marché des GPU de calcul haute performance pour l’IA. Cette concentration de pouvoir soulève des questions légitimes sur la résilience du système. Que se passe-t-il si des tensions géopolitiques perturbent la chaîne d’approvisionnement ? Que se passe-t-il si NVIDIA abuse de sa position dominante pour imposer des prix prohibitifs ?

Les entreprises doivent anticiper ces risques en diversifiant leurs sources d’infrastructure GPU (AMD, Google TPU, solutions spécialisées) et en développant des architectures hybrides qui ne dépendent pas exclusivement d’un seul fournisseur.

La Question Énergétique et Environnementale

L’autre limite majeure de cette industrialisation de l’intelligence est sa consommation énergétique. Les data centers GPU consomment des quantités d’électricité colossales. À mesure que l’usage de l’IA se généralise, cette consommation ne fera qu’augmenter.

Cette réalité impose de repenser la soutenabilité énergétique de l’économie IA. Les entreprises et les gouvernements devront massivement investir dans les énergies renouvelables pour alimenter ces infrastructures. Sans cela, l’industrialisation de l’intelligence pourrait devenir un désastre environnemental.

Perspectives : L’Avenir Appartient aux Infrastructures Invisibles

L’IA comme Couche Fondamentale de l’Économie Numérique

La vision de Jensen Huang dessine un avenir où l’intelligence artificielle n’est plus perçue comme une technologie émergente, mais comme une couche fondamentale de l’économie numérique, au même titre que l’électricité dans l’économie industrielle.

Dans ce monde, personne ne se posera la question de savoir si l’IA est « rentable » ou si c’est une « bulle ». On ne se pose pas ces questions pour l’électricité. On se contente de constater que sans elle, rien ne fonctionne.

Les Gagnants Seront Ceux qui Construisent les Tuyaux

Comme dans toutes les révolutions infrastructurelles, les gagnants ne seront pas nécessairement ceux qui construisent les applications les plus visibles, mais ceux qui construisent les infrastructures indispensables.

Pendant la ruée vers l’or californienne, les gens qui se sont enrichis durablement n’étaient pas les chercheurs d’or. C’étaient ceux qui vendaient les pelles, les pioches et les pantalons renforcés. Dans la révolution IA, NVIDIA vend les pelles. Et ceux qui s’enrichiront seront ceux qui contrôlent l’accès à cette puissance de calcul devenue indispensable.

Pour les entreprises, cela signifie une chose : investir dès maintenant dans la capacité de calcul IA n’est pas une spéculation. C’est une assurance stratégique. C’est sécuriser l’accès à l’infrastructure critique qui définira la compétitivité de demain.

Conclusion : L’Industrialisation de l’Intelligence Redéfinit les Règles

Jensen Huang a raison. L’IA n’est pas un cycle logiciel. C’est une révolution industrielle. Et comme toutes les révolutions industrielles, elle ne se déploie pas en bulles spéculatives qui éclatent. Elle redéfinit profondément et durablement l’économie.

Ceux qui comprennent cette distinction fondamentale — la différence entre un produit fini et une production continue, entre un logiciel statique et une usine d’intelligence toujours active — construisent déjà l’avenir. Ceux qui continuent à analyser l’IA avec les outils conceptuels du logiciel traditionnel passeront à côté de la transformation en cours.

Pour les dirigeants, architectes, designers et entrepreneurs qui façonnent les espaces et les entreprises de demain, le message est clair : l’infrastructure GPU devient aussi critique que l’électricité. La dépendance du monde à cette infrastructure croît chaque jour. Et ceux qui sécurisent aujourd’hui leur accès à cette puissance de calcul prennent une longueur d’avance décisive.

L’IA n’est pas une mode passagère. C’est l’industrialisation de l’intelligence. Et cette industrialisation, comme toutes celles qui l’ont précédée, redéfinit les règles du jeu pour les décennies à venir.